Chirurg aus der Ferne

TU-Forschende entwickeln KI für Operationen auf Distanz

05.07.2022 von Boris Hänßler

OP-Roboter benötigen hochqualifizierte Assistenten – an denen es weltweit mangelt. Eine an der TU Darmstadt entwickelte Künstliche Intelligenz soll Fernoperationen auch ohne sie ermöglichen.

Vor wenigen Jahren erschien ein Bericht der Lancet Commission on Global Surgery, der zeigte, dass in Ländern mit hohem Einkommen auf 100.000 Menschen im Durchschnitt etwa 71 Fachärzte für Chirurgie kommen, in Ländern mit mittlerem Einkommen sind es 24 und in Ländern mit niedrigem Einkommen nur einer. Mehr als zwei Milliarden Menschen erhalten demnach keine chirurgische Versorgung.

Das ist nicht nur ein Problem der globalen Gesundheit – selbst in den ländlichen Gebieten Deutschlands gibt es bereits einen Mangel. Durch die Corona-Pandemie hat sich die Situation sogar noch einmal verschärft. Die chirurgische Ausbildung wurde aufgrund der Überlastung der Gesundheitsinfrastruktur vernachlässigt. Die Auswirkungen werden erst in einigen Jahren zu spüren sein.

Sogenannte Operations-Roboter wie „DaVinci“ könnten dem entgegenwirken, aber sie verlangen hochqualifizierte Assistenten. Ein Chirurg oder eine Chirurgin sitzen bei diesen Systemen an einer Konsole, und die ist fast vollständig vom Roboter getrennt. Meist gibt es zwei ausgebildete Assistenzpersonen, die dafür sorgen, dass die benötigten Instrumente in die Hände des Roboters gelangen oder dass Endoskope an der richtigen Stelle ansetzen, damit die Sicht intakt bleibt.

Unser Ziel ist , künftig alle Menschen, die in Not sind, chirurgisch zu versorgen – damit sie nicht in Ballungszentren reisen müssen, was zudem auch ein schwieriges logistisches Problem ist.

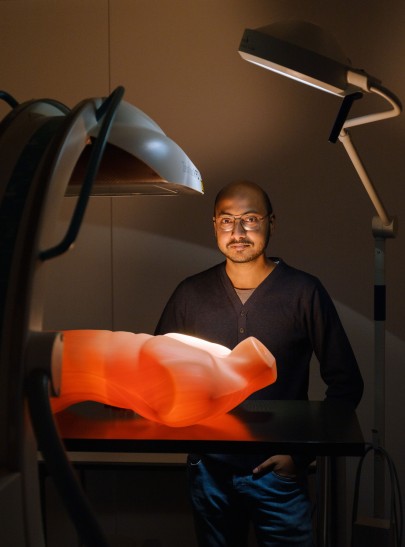

Anirban Mukhopadhyay, Leiter der Unabhängigen Nachwuchs-Forschungsgruppe MEC-Lab

Chirugie als komplexer Prozess

„Wir können uns vorstellen, dass wir mit der heutigen Netzwerkbandbreite die Konsole einfach an jeden beliebigen Ort der Welt bringen können, egal wo“, sagt Informatiker Anirban Mukhopadhyay, Leiter der Unabhängigen Nachwuchsforschungsgruppe Medical and Environmental Computing (MEC-Lab) an der TU Darmstadt. „Und wenn die Bandbreite stabil genug ist, kann man auch aus der Ferne operieren. Aber wo finden wir diese geschulten chirurgischen Assistenten, die während des Eingriffs vor Ort sind und helfen?“

Die Forschenden um Mukhopadhyay entwickeln daher eine Künstliche Intelligenz, die diese Assistenzaufgaben in abgelegenen und ländlichen Gegenden übernehmen oder weniger qualifiziertes Personal dabei unterstützen kann. Die bisherigen Forschungen im Bereich der Künstlichen Intelligenz – insbesondere in der Bildanalyse – reichen dafür nicht aus. Um zum Beispiel einen chirurgischen Arbeitsablauf zu analysieren, werden klassische Methoden aus der Computer Vision und DeepLearning-Algorithmen mit minimalen Änderungen so angepasst, dass sie mit den chirurgischen Bilddaten zurechtkommen. Dabei werden vor allem die Pixel der Videos betrachtet, um eine Klassifizierung vorzunehmen.

Aber das wird der Chirurgie nicht gerecht. Sie ist ein komplexer Prozess. Es braucht viel Kommunikation, da im OP-Saal laufend Veränderungen auftreten. Zudem mangelt es an Daten, mit denen eine Künstliche Intelligenz trainiert werden kann – für Bildanalysen werden oft Datensätze im fünfoder sechsstelligen Bereich genutzt, aber diese stehen bei Operationen nicht zur Verfügung. In der Chirurgie wird man nie viele Beispiele bekommen, weil jede Operation etwas anders ist.

„Wir haben uns überlegt, wie wir von Formen im Bild, statt von Pixeln ausgehen können“, sagt Mukhopadhyay. „Chirurgen interessieren sich für die anatomische Form, die Elastizität dieser verschiedenen Formen und wie man operieren kann, was man berühren kann und was man nicht berühren soll. Wir haben also versucht, diese Ideen in die Deep-Learning-Algorithmen einzubringen.“ Formen treten nur mit einer bestimmten Topologie oder einer bestimmten Geometrie auf. Wenn eine KI diese Aspekte erkennen kann, dann braucht sie weniger Daten, um zu lernen.

Beispiel Cochlea-Implantate

Ein Beispiel sind Cochlea-Implantate, Gehörprothesen, die im Innenohr eingesetzt werden. Die Prothesen bestehen aus zwei Komponenten: dem eigentlichen Implantat und einem Sprachprozessor, der wie ein Hörgerät hinter dem Ohr getragen wird. Ein darin befindliches Mikrofon nimmt akustische Signale auf. Diese werden im Sprachprozessor in elektrische Signalmuster umgewandelt und durch die Haut über eine Sendespule an das Implantat gesendet. Das Implantat gibt sie an Elektroden weiter, die die Hörnerven stimulieren.

Um die Künstliche Intelligenz zu trainieren, nutzen die Forscher präoperative Computertomographie-Scans des Kopfes. Diese werden angefertigt, um die Operationen zu planen – etwa wie die Sonde eingeführt und die Elektrode in der Cochlea platziert wird. Der Patient muss also nicht zusätzlich bestrahlt werden, um Trainingsdaten zu erstellen. Wenn die Algorithmen in diesen Scans etwa den oberen, mittleren und unteren Teil eines Nervs finden, dann weiß der Roboter, wo er die Verbindung mit dem Implantat herstellen kann. Das System muss also nicht jeden Pixel auf dem Bild berücksichtigen, sondern nur die Formen identifizieren. Das hat den Vorteil, dass weniger Trainingsbilder für das Deep Learning benötigt werden.

„Wir konnten zeigen, dass unsere Algorithmen schon bei 15 bis 20 Beispielen robust funktionieren“, sagt Mukhopadhyay. Aufbauend auf dieser Idee der Formkonsistenz führten die Forscher das sogenannte Supervised Contrastive Learning ein – die KI lernt dabei allein durch die Betrachtung simulierter Bilder, chirurgische Instrumente aus echten laparoskopischen Bauchoperationen zu segmentieren.

Unvorhersehbare Ereignisse

Ein schwieriges Problem ist noch, dass bei einer Operation Ereignisse eintreten, die selbst solch eine Bildanalyse erschweren. Bei der Interaktion zwischen Instrument und Gewebe kann es etwa zu Blutungen kommen. Dadurch ändert sich das Aussehen der Szene, mitunter verdeckt Blut das Instrument. Auch werden Werkzeuge benutzt, die das Gewebe verbrennen und Rauch erzeugen. Die Kamera kann zudem zu nahe am Instrument sein und Reflexionen im Metall bewirken. Der Roboter muss dann erkennen, was passiert ist.

Dank dieser Forschungen könnte in Zukunft ein Chirurg von seinem Arbeitsplatz aus dann überall in der Welt Operationen ausführen. Dabei wird die gesamte Operation in kleine Phasen aufgeteilt. Jeder Roboter würde jede Phase identifizieren und den Chirurgen mitteilen, wie wahrscheinlich es ist, dass der Roboter eine Aktion selbst durchführen kann. Wenn er dazu nicht in der Lage ist, haben die Chirurgin oder der Chirurg die Möglichkeit, die komplette Kontrolle zu übernehmen. Roboter und Chirurgen kommunizieren und interagieren dann so ähnlich wie ärztliches Personal und Assistenzmitarbeitende – und die erkrankten Menschen erfreuen sich einer vergleichbaren medizinischen Versorgung wie in einer Fachklinik.