Bis vor wenigen Jahren mussten intelligente Systeme (wie z. B. Sprachassistenten und Fertigungsroboter) präzise auf ihre Aufgabe und ihre Umgebung eingestellt werden. Sie mussten von Expertinnen und Experten programmiert werden. Seit einigen Jahren findet aber ein Paradigmenwechsel in der KI statt: Statt alle Schritte der Wissensverarbeitung manuell zu kodieren, wird den Maschinen die Fähigkeit zu lernen, einprogrammiert. Mit Hilfe dieses Maschinellen Lernens (ML) kann man Maschinen mit einer sehr großen Zahl von Beispielsituationen trainieren, die sie dann mittels Mustererkennung auf neue, aber sehr ähnliche Situationen übertragen. Die größten KI-Erfolge basieren zur Zeit auf tiefen neuronalen Netzen (Deep Learning), die durch den Aufbau des menschlichen Gehirns inspiriert sind. Eine große Zahl an künstlichen Neuronen, die in Schichten organisiert und vernetzt sind, verarbeitet unter hohem Rechenaufwand eine große Menge an Daten. Und obwohl Experten im Prinzip verstehen, wie Lernen in diesem System funktioniert — schließlich haben sie das System gebaut — lässt sich dessen erlerntes, intelligentes Verhalten aufgrund seiner großen Komplexität auch von Experten nicht mehr nachvollziehen oder gar vorhersagen. Das Modell wird zur Blackbox und es stellt sich die Frage: „Können wir die Entscheidungen von tiefen Netzen, und von KI-Algorithmen allgemein, nachvollziehen und ihnen vertrauen?“

WhiteBox – Erklärbare Modelle für menschliche und künstliche Intelligenz

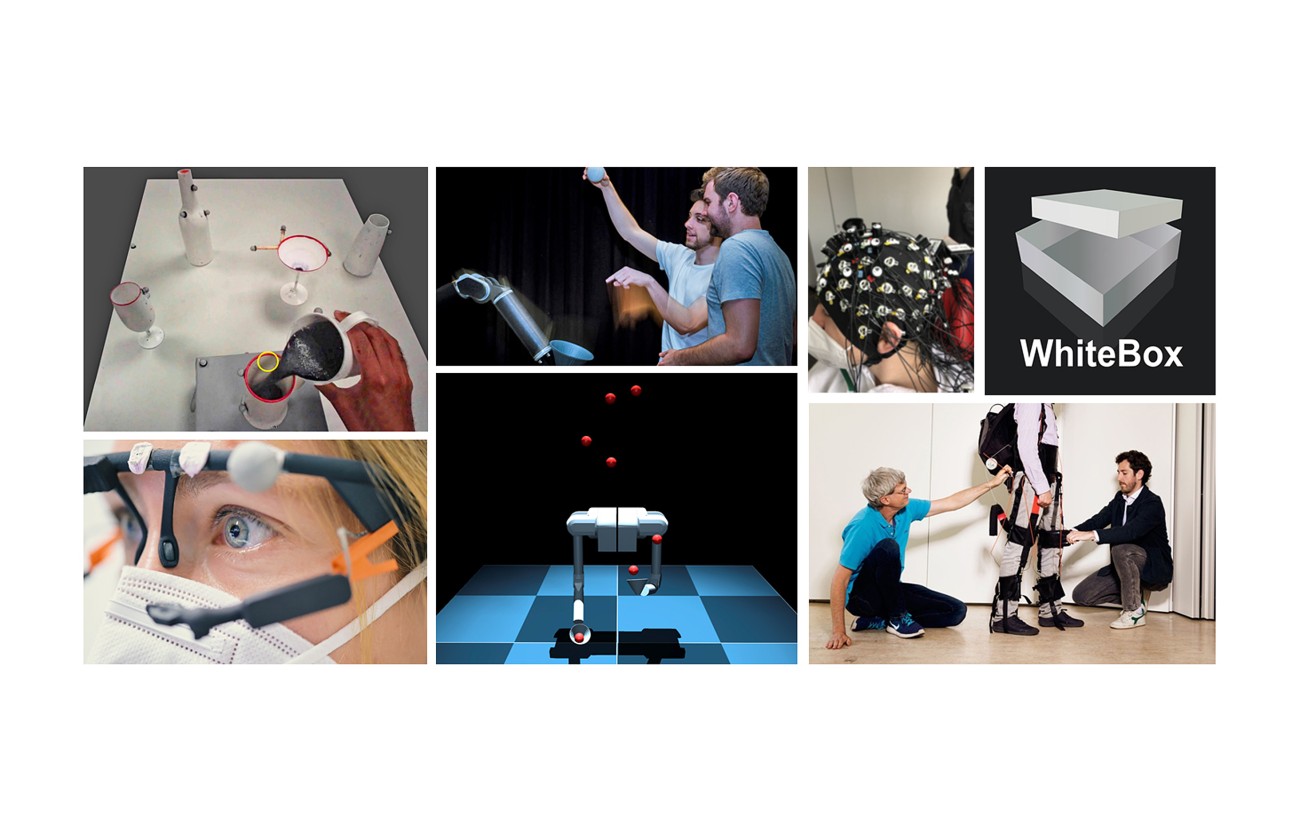

Der vom hessischen Ministerium für Wissenschaft und Kunst (HMWK) geförderte LOEWE-Schwerpunkt WhiteBox zielt darauf ab, Methoden an der Schnittstelle zwischen der Kognitionswissenschaft und der KI-Forschung zu entwickeln, um menschliche und künstliche Intelligenz besser zu verstehen

Projektvorstellung

Die Aufgabe, Verhalten einer künstlichen Intelligenz zu erklären, unterscheidet sich nicht wesentlich von der Aufgabe, intelligentes Verhalten in Menschen zu erklären. Auch dieses basiert auf einer großen Zahl von Neuronen im Gehirn und gelernten Erfahrungen. Eine Erklärung jedoch, die auf dem kompletten Schaltplan des Gehirns und all seiner Interaktionen mit der Umwelt beruht, ist keine verständliche Erklärung. Erklärungen für intelligentes Verhalten müssen daher auf einer abstrakten Ebene erfolgen: Es müssen kognitive Erklärungen sein. Solche liefert die Kognitionswissenschaft. WhiteBox verwandelt also mittels kognitiver Erklärungen Blackbox-Modelle der KI in Whitebox-Modelle, die von vornherein erklärbar sind.

Im Sinne dieser Leitidee wird der LOEWE-Schwerpunkt Blackbox- und Whitebox-Modelle für künstliche und menschliche Intelligenz entwickeln und systematisch vergleichen. Für den Vergleich werden neben neuartigen Blackbox- und Whitebox-Modellen und ihrer empirischen Gegenüberstellung auch neue Erklärungsmethoden entwickelt, die nicht eine gesamte Blackbox erklären, sondern gezielte Einblicke gewähren. Die betrach¬teten Blackbox-Modelle werden beispielsweise tiefe Netzwerke sein, die Whitebox-Modelle hingegen werden unter anderem regelbasierte, probabilistische und generative Modelle nutzen, mit expliziten und interpretierbaren Variablen. Die Anwendung auf intelligentes Verhalten beim Menschen erlaubt es, dieses computergestützt besser zu verstehen und gleichzeitig erklärbares, menschenähnliches Verhalten in Maschinen aufzubauen.

News

-

![]() Bild: Markus Scholz für die Leopoldina

Bild: Markus Scholz für die Leopoldina![]() Bild: Markus Scholz für die Leopoldina

Bild: Markus Scholz für die Leopoldina„Wissen versus Meinung“ @ Leopoldina

28. November 2025

Spielerisch Wissenschaft und Demokratie von innen stärken: ProLOEWE mit Wissenschaftsplanspiel „Wissen versus Meinung“, am 28. November 2025 zu Gast bei der Leopoldina in Halle.

-

![]() Bild: Fabian Wolf

Bild: Fabian Wolf![]() Bild: Fabian Wolf

Bild: Fabian Wolf„Zwei Wissenschaftler im Tiefenrausch“

31. Oktober 2025

ProLOEWE Interview mit den WhiteBox Sprechern Constantin Rothkopf und Kristian Kersting

-

![]() Bild: 2025 TU Darmstadt

Bild: 2025 TU Darmstadt![]() Bild: 2025 TU Darmstadt

Bild: 2025 TU DarmstadtWebAI Hackathon 2025

28. Juli 2025

Innovative Webanwendungen mit neuem KI-Framework

Vom 23. bis 25. Juli 2025 wurde die TU Darmstadt zum Treffpunkt für kreative Webentwicklung: Beim WebAI Hackathon entwickelten sechs Teams in nur drei Tagen funktionsfähige Webanwendungen mit integrierter KI-Komponente.

Newsticker

31. Dezember 2025 – Nach fünf Jahren Spitzenforschung an der Schnittstelle zwischen Kognitionswissenschaft und KI wurde der LOEWE-Schwerpunkt WhiteBox erfolgreich abgeschlossen.

Mit Jahresbeginn 2026 haben im Anschluss die Exzellenzcluster EXC 3066 ‘The Adaptive Mind’ (TAM) und EXC 3057 ‘Reasonable Artificial Intelligence’ (RAI) begonnen und werden diese erfolgreiche Grundlagenforschung in einem erweiterten Rahmen fortsetzen.

28. November 2025 – „Wissen versus Meinung“. ProLOEWE besucht die Nationale Akademie der Wissenschaften und präsentiert ein von WhiteBox mitentwickeltes Planspiel zum Thema Künstliche Intelligenz. Mehr erfahren

Oktober 2025 – „Zwei Wissenschaftler im Tiefenrausch“. ProLOEWE Interview mit den WhiteBox-Sprechern Constantin Rothkopf und Kristian Kersting. Mehr erfahren

23. Oktober 2025 – Herzlichen Glückwunsch! Claire Ott hat ihre Dissertation „Explaining Decisions: On Problem Solving and Analogical Reasoning in Human-Centered Explainable AI“ erfolgreich verteidigt. Die Arbeit wurde von Prof. Dr. Frank Jäkel und Prof. Dr. Kai-Uwe Kühnberger betreut. Mehr erfahren

20. Oktober 2025 – Herzlichen Glückwunsch! Omid Mohseni hat seine Dissertation „Synthesis of Legged Locomotion in Humans and Machines Through Force Based Concerted“ erfolgreich verteidigt. Die Arbeit wurde von Prof. Dr. Mario Kupnik und Prof. Dr. André Seyfarth betreut.

15. Oktober 2025 – Herzlichen Glückwunsch! Asghar Mahmoudi Khomami hat seine Dissertation „The Design Optimization Platform: A Predictive Simulation-based and User-centered Design Framework for Assistive Wearable Devices“ erfolgreich verteidigt. Die Arbeit wurde von Prof. Dr.-Ing. Stephan Rinderknecht und Prof. Dr. André Seyfarth betreut.

1.-5. September 2025 – Die International Interdisciplinary Computational Cognitive Science Summer School (IICCSSS) 2025 fand vom 1. bis 5. September im Centre for Cognitive Science in Darmstadt mit rund 70 teilnehmenden Studierenden statt. Das Programm umfasste Keynote-Vorträge, Poster- und Paper-Sessions, Laborbesichtigungen und einen interaktiven Hackathon. WhiteBox öffnete im Rahmen der Laborbesichtigungen das Roboterlabor und das Lauflabor und präsentierte Ergebnisse und laufende Forschungsarbeiten. Mehr erfahren

23.-25. Juli 2025 – WebAI Hackathon 2025 – Innovative Webanwendungen mit neuem KI-Framework. Teams von Studierenden entwickelten mit einem neuen Framework in nur drei Tagen kreative Webanwendungen mit integrierter KI-Komponente. Mehr erfahren

10. Juli 2025 – Im Rahmen der internationalen Konferenz AMAM/LokoAssist 2025 hat WhiteBox am 10. Juli Ergebnisse seiner Arbeiten präsentiert im Workshop „WhiteBox – Whitebox Modelling of Human Movement“. Mehr erfahren

25. Mai 2025 – Im Rahmen der Verleihung des xchange-Preises 2025 der TU Darmstadt wurde das ProLOEWE-Planspiel „Wissen vs. Meinung: Künstliche Intelligenz“ auf dem Open Campus Day in der Kategorie Wissenstransfer & Wissenschaftskommunikation belobigt. Mehr erfahren

22. Mai 2025 – Großer Erfolg für die Technische Universität Darmstadt – und das Centre for Cognitive Science: Die Exzellenzkommission im Wettbewerb der prestigeträchtigen Exzellenzstrategie des Bundes und der Länder wählte die Anträge „The Adaptive Mind“ (TAM) und „Reasonable Artificial Intelligence“ (RAI) aus den Themenfeldern Kognitionswissenschaft und Künstliche Intelligenz zur Förderung aus. Mehr erfahren

Mai 2025 – Endspurt der Exzellenzstrategie. Die Entscheidung über die Förderung der Exzellenzcluster fällt im Mai 2025, die eigentliche Förderung der ausgewählten Projekte startet dann zum 1. Januar 2026 für einen Zeitraum von sieben Jahren. Die Erstellung der hessischen Exzellenz Anträge hat sehr von der Förderung durch das Land Hessen profitiert. Mehr erfahren

14. April 2025 – Herzlichen Glückwunsch! Matthias Schultheis hat seine Dissertation „Inverse Reinforcement Learning for Human Decision-Making Under Uncertainty“ erfolgreich verteidigt. Die Arbeit wurde von Prof. Dr. Heinz Koeppl und Prof. Constantin A. Rothkopf, Ph.D., betreut. Mehr erfahren

5. Februar 2025 – Auf Einladung von WhiteBox und dem Centre for Cognitive Science stellte David Franklin (Technical University of Munich) heute in Darmstadt seine Arbeit über „Computational Mechanisms of Human Sensorimotor Adaptation“ vor und diskutierte unsere wissenschaftlichen Ansätze.

20. November 2024– Auf Einladung von WhiteBox und dem Centre for Cognitive Science stellte Anna Hughes (University of Essex) heute in Darmstadt ihre Arbeit über „Hide and seek: the psychology of camouflage and motion confusionl“ vor und diskutierte unsere wissenschaftlichen Ansätze.

6. November 2024 – Auf Einladung von WhiteBox und dem Centre for Cognitive Science stellte Mate Lengyel (University of Cambridge) heute in Darmstadt seine Arbeit über „Normative models of cortical dynamics“ vor und diskutierte unsere wissenschaftlichen Ansätze.

23. Oktober 2024 – Auf Einladung von WhiteBox und dem Centre for Cognitive Science stellte Leonie Oostwoud Wijdenes (Radboud University Nijmegen) heute in Darmstadt ihre Arbeit über „Variability in sensorimotor control“ vor und diskutierte unsere wissenschaftlichen Ansätze.

Oktober 2024 – Das WhiteBox-Forscherteam traf sich vom 07. bis 11. Oktober am Laacher See in der Eifel zum dritten Retreat. Hauptthemen waren der interdisziplinäre wissenschaftliche Austausch und die Diskussion des aktuellen Stands der Arbeiten.

17. Juli 2024 – Auf Einladung von WhiteBox und dem Centre for Cognitive Science stellte Jozsef Fiser (Central European University, Wien, Österreich) heute in Darmstadt seine Arbeit über „Complex perceptual decision making processes in humans“ vor und diskutierte unsere wissenschaftlichen Ansätze.

15. Juli 2024 – WhiteBox engagiert sich im Wissenschaftsplanspiel „Wissen versus Meinung“ an hessischen Schulen. Das Planspiel führt Schülerinnen und Schüler an die Bedeutung von Wissenschaft und Demokratie heran. Mehr erfahren

10. Juli 2024 – Auf Einladung von WhiteBox und dem Centre for Cognitive Science stellte Ralf Haefner (University of Rochester) heute in Darmstadt seine Arbeit zum Thema „Causal inference during motion perception, and its neural basis“ vor und diskutierte unsere wissenschaftlichen Ansätze.

Juni 2024 – Vom 13. bis 14. Juni 2024 fand in Bensheim (bei Darmstadt) die 4. Bewegungsakademie mit über 50 Teilnehmer:innen aus unterschiedlichen beruflichen und akademischen Hintergründen im Bereich der menschlichen Bewegung und des Lernens statt, hauptverantwortlich organisiert durch die DFG-Fördergruppe LokoAssist. Ziel der Movement Academy ist es, einen einzigartigen Lernraum für nationale und internationale Bewegungsexperten und -interessierte, die aus unterschiedlichen Bereichen wie Kunst, Sport, Medizin, Therapie und Wissenschaft kommen, zu schaffen. Die Konferenz wurde unter anderem vom Center for Cognitive Science und aufgrund der behandelten Themen auch vom WhiteBox-Forschungscluster unterstützt. Mehr erfahren

12. Juni 2024 – Auf Einladung von WhiteBox und dem Centre for Cognitive Science stellte Maria Eckstein (Google DeepMind) heute in Darmstadt ihre Arbeit „Hybrid Modeling with Artificial Neural Networks Reveals how Memory Shapes Human Reward-Guided Learning“ vor und diskutierte unsere wissenschaftlichen Ansätze.

25. April, 2024 – WhiteBox unterstützte den diesjährigen Girls' Day, um die Neugier und das Interesse an der Kognitionswissenschaft zu fördern. Die Teilnehmerinnen beschäftigten sich in spannenden Sitzungen mit verschiedenen Themen aus dem Forschungsbereich. Mehr erfahren

April 2024 – WhiteBox unterstützt die Awareness-Veranstaltung: „Aufgedeckte Vorurteile: Die Macht der Bewusstheit im Umgang mit Unconscious Bias“ am 24 April 2024. Mehr erfahren

Januar 2024 – Forschende des WhiteBox-Projektes am Centre for Cognitive Science der TU Darmstadt und von hessian.AI untersuchen in einer Publikation in der renommierten Fachzeitschrift „Nature Human Behaviour“ die Eigenschaften von durch Künstliche Intelligenz automatisch gelernten verhaltensökonomischen Theorien. Die Studie unterstreicht, dass die Kognitionswissenschaft noch immer nicht einfach durch künstliche Intelligenz automatisiert werden kann und dass eine sorgfältige Kombination von theoretischen Überlegungen, maschinellem Lernen und Datenanalysen erforderlich ist, um zu verstehen und zu erklären, warum menschliche Entscheidungen sind, wie sie sind, und vom mathematischen Optimum abweichen. Mehr erfahren

Projektdetails

- Projekt: WhiteBox – Erklärbare Modelle für menschliche und künstliche Intelligenz

- Projektpartner: Technische Universität Darmstadt

- Projektdauer: Januar 2021 – Dezember 2025

- Projektmittel: 4.7 Mio EUR

- Gefördert durch: Hessisches Ministerium für Wissenschaft und Kunst

- Förderlinie: LOEWE Schwerpunkt, 13. Förderstaffel

- Förderkennzeichen: LOEWE/2/13/519/03/06.001(0010)/77